自动驾驶撞人责任问题

本文摘录自 大问题:自动驾驶汽车撞了人,责任算谁的?

问题描述

我们今天说的自动驾驶汽车是那种完全的自动驾驶,也就是业界说的 L5 级别的自动驾驶,完全不需要人类操控的那种级别。当然,现在离这种级别自动驾驶的普遍应用还有一段路要走,还需要克服一些技术难题,但是所谓的技术问题也只是时间的问题,相信过不了多久,就像最近突然开始爆发的 GPT 一样,完全自动化的人工智能汽车也会突破技术难题,能做到普遍应用。

我们假定这些技术难题都已经解决了,解决的标志之一就是,自动驾驶汽车发生交通事故的概率要明显低于人类驾驶汽车了,自动驾驶汽车的发展普及能减少交通事故,因为人类开车总会犯错、犯困、疏忽、大意,酒驾、看手机,甚至会故意开车去大街上撞人,但是,人工智能就不存在这样的问题,人工智能开车在技术上比人类开车更少出错。而且,随着自动驾驶越是普及开来,交通事故会越少发生,因为车与车之间、车与路之间是联网协同的,其中有个网络效应,等到路面上开的大部分的车都是自动驾驶车,交通事故的发生概率又会有进一步质的降低。

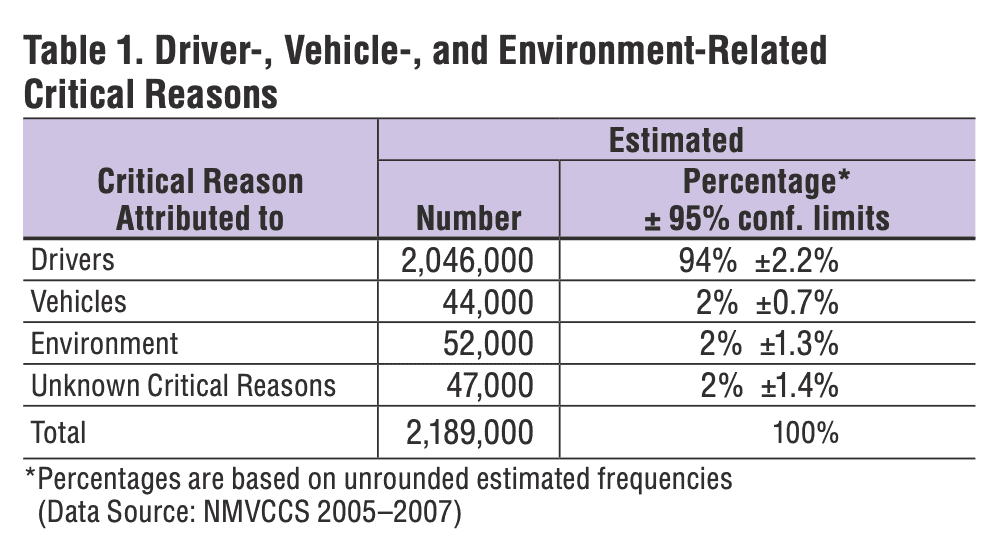

到底能降低多少?要知道,绝大部分的交通事故都是人为因素导致的,根据美国国家公路交通安全管理局 NHTSA 的数据,94% 的交通事故都是由司机的人为因素导致的。麦肯锡公司之前发布过一份研究报告,预测到 2030 年,自动驾驶汽车发展普及以后,将使交通事故至少降低 90%。

降低 90% 是什么概念呢?大家要知道,造成地球人死亡的原因里面,交通事故排第 8 名,而且这是把所有原因都算进来了,包括心脏病、癌症、糖尿病这些因为年纪大才会得的病,那如果排除掉老人只看 5-29 岁的年轻人,交通事故是造成年轻人死亡的头号杀手!根据世界卫生组织的数据,全球每年大约有 130 万人死于交通事故,这只是死亡数字,如果算上撞伤撞残疾的人,那就是一个更恐怖的数字——5000 万。自动驾驶能至少降低 90% 的交通事故意味着,每年能有数以百万计的生命得到挽救、数以千万计的人免于受伤致残。

提这些数字是为了说明,我们没有理由拒绝自动驾驶汽车的发展普及,自动驾驶是大势所趋。那么,接下来问题就来了,自动驾驶的发展普及同时也会造成一些我们曾经从未遇倒过的伦理困境:虽然自动驾驶比人类驾驶更安全,但是它再安全也不可能 100% 安全,因为自动驾驶汽车毕竟是个高速行驶的、大质量的物体,物理学决定了它还是不可避免地会撞到人,那么问题来了,一旦自动驾驶汽车撞了人,这责任算谁的?

按照传统的人类驾驶汽车,一旦撞了人,责任主要是算司机的,人类司机就是肇事人,但是在完全自动驾驶汽车里面坐着的车主,他无法自主操控汽车,与其说他是车主,不如说是乘客。汽车撞了人,如果乘客来负责的话,这就很奇怪。但是另一方面,若是让制造自动车的厂商来负责的话,这也很奇怪,因为厂商也无法预料这个人工智能汽车在出厂交付给某个特定车主以后会怎么行驶,那么,难不成是这个人工智能汽车自己来负责吗?

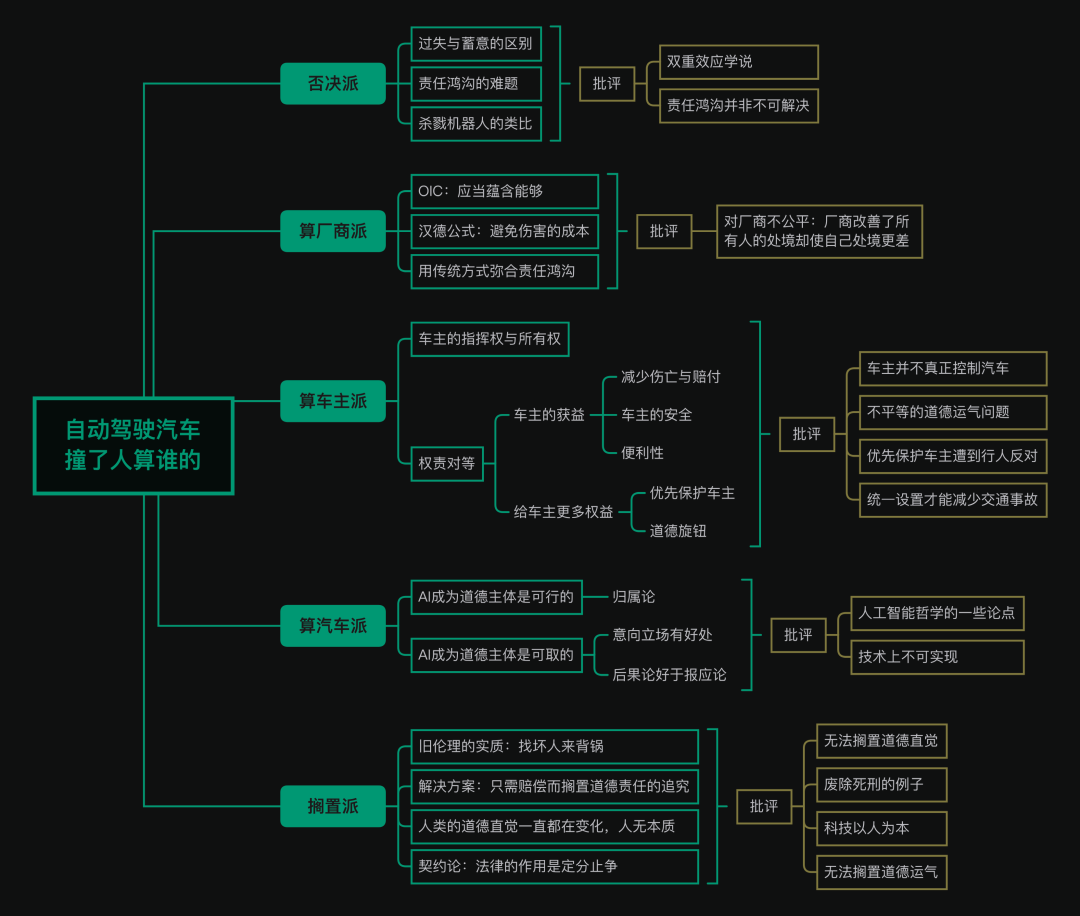

否决派

否决派主张否决自动驾驶的发展,因为这造成了伦理上不可接受的后果

严重后果一:人类驾驶撞人是过失致人死亡,而自动驾驶汽车是故意致人死亡

电车难题的发生:如果换做是 AI 汽车的话,程序员在事先编写 AI 代码以及训练 AI 的时候,必然会提前考虑这么一种情况,这就说回到开篇提到的场景了,自动驾驶汽车要么不拐弯撞死前方的行人张三,要么拐弯撞墙因而撞死车里的车主李四,程序员在事先写代码的时候,肯定要为这种二选一或者多选一的情况赋予优先级。但是,一旦事先做了选择,无论怎么选,这个交通事故造成的死亡就不是意外了,这就是在故意制造死亡——编程的时候如果选择拐弯的话,那么行人张三的死就是提前谋划好的;如果选择不拐弯的话,那么车主李四的死就是提前谋划好的。

同样的,依然是那辆高速行驶的自动驾驶汽车,依然是车速太快刹不住了,眼看就要撞到前方的行人了,但是此时前方的行人,不是只有 1 个人了,而是有 5 个人,同样地,此时的自动车的传感器发现有一条岔道可以拐弯,这个岔道上呢,只有 1 个行人,名叫张三,那么请问,自动驾驶车的程序设置是应当拐弯撞死张三用 1 条命换另外 5 条命吗?这就是经典的电车难题了,相信依据多数人的直觉呢,我们觉得这个程序设置是应当拐弯,毕竟这能最大限度地减小伤亡。

严重后果二:出现责任鸿沟(Responsibility Gap)难题。

责任鸿沟:所谓责任鸿沟简单说就是,实施某种行为的东西,它不是道德主体,而给这些东西发号施令的人以及使用这个东西的人又不能准确预测会发生什么,因此最终造成的局面就是,没有人能够为这个行为负责。

杀戮机器人假想:杀戮机器人(Killer Robot)其实就是人工智能士兵,现在人工智能时代来临,上战场杀敌的士兵也无须是人类士兵,我们只需要造人工智能的机器人士兵去杀敌就好了。造这种杀戮机器人,和这个自动驾驶汽车一样,也会带来很大的功效上的好处,首先是避免己方的士兵的伤亡,对于敌方也是有好处的,因为这个人类士兵在战争中经常会误杀平民,比如说搞错了、疏忽了,或者就是因为发怒了想要报复就滥杀平民,跟这个人类开车会出错一样,但这种事情在人工智能士兵身上不会出现,这个人工智能士兵会非常冷静地计算敌方有威胁的军力在哪,并且以一种非常精确地不造成平民伤亡的方式,杀灭敌方有生力量。听起来这个杀戮机器人很不错。

批评

针对第一个问题,可以用双重效应学说(Doctrine of Double Effect) 使得在伦理上可接受。

双重效应学说:双重效应说,最初是由欧洲中世纪的神学家托马斯·阿奎那提出来的,本来,是处理关于正当防卫的问题的,就是说,如果一个人杀了人,但是如果这种杀人的行为,是为了保护自己,那杀人就可以是正当的,这就是正当防卫。

这个学说整理一下,一种行为如果造成了坏的后果,如果这个行为同时满足以下三个条件,则可以用双重效应学说为此进行辩护。 第一,你的动机是为达到一个善的目的。 第二,你的行为造成的坏的后果呢,是作为一种预见到的副效应而遗憾地发生的,并不是你故意要追求这种恶果。 第三,你尽量将坏的效果降到最低,也就是说,这是你能选择的最不坏的选项。

我们发展自动驾驶车的动机,是为了从总体上减少交通事故的伤亡,这是一个善的目的,因此满足第一点,那第二点也是满足的,自动车撞了人,是我们不愿意发生的,它是一个遗憾,但是最终我们还是决定发展自动驾驶车,是因为它比人类驾驶能实现更小的伤亡,这是一个更不坏的选项,第三点满足。则发展自动驾驶汽车可以受到辩护。

因为杀戮机器人我们直观起来是不可接受的事物,而自动驾驶汽车和杀戮机器人的道理是一样的,所以我们也不应当接受自动驾驶汽车,但是,杀戮机器人能是一样的吗?刚刚我们说了这个双重效应学说,确实,双重效应学说无法为杀戮机器人作辩护,但是可以为自动驾驶汽车作辩护,为什么前者不能后者能,因为两者是不一样的,我们看那个双重效应说的第一个要件,制造杀戮机器人的目的就是为了杀人,但我们制造自动驾驶汽车的目的是为了杀人吗?完全不是一回事。因此,可以通过这个学说反驳杀戮机器人假想。

接下来就是责任鸿沟问题的解决,将责任归结于厂商,买家,和人工智能本身。

责任由厂商承担

OIC 原则:伦理学里面说一个人应不应当负责,要讲求一个原则,就是 OIC 原则,Ought Implies Can,「应当」蕴含「能够」,你说我应当做什么事情的前提,是我能够做到,比如说,你说我应当带领中国队勇夺世界杯冠军,但是我其实是一个武术选手,我上场只会正蹬、鞭腿、左刺拳,你让我踢球,我踢不了,没那个能力。

同样,你说我作为车主应当为这次撞人的事故负责,前提是我能够做到控制这辆车让它不撞人,但是我能控制得了这辆自动驾驶汽车吗?控制不了,没那个能力,所以我车主就不应当承担这个责任。这个说法的根基在于预设车主控制不了自动驾驶汽车。

汉德公式:法律经济学里面有一条著名的汉德公式(Learned Hand Formula),这个公式也就是来判定,一旦发生意外事故造成损失,谁该来为此负责。这个汉德公式一共有三个变量,第一个是 B,B 也就是为了避免这个意外事故所要花费的成本,第二个变量是 P,也就是发生意外的概率,第三个变量是 L,也就是意外所造成的损失。汉德公式就是 B 要小于 P 乘以 L。

B < P·L,其中: B:避免意外的成本 P:发生意外的概率 L:意外造成的损失

这个汉德公式放在自动驾驶汽车撞人的语境中,简单说也就是,车主和厂商哪一方,为了避免意外发生所花费的成本更小?或者说,如果做一件事就能够避免意外发生,而你做这件事情比我做这件事情更轻松,那么这个责任就应当由你来扛。

而对于厂商而言,这个自动驾驶汽车的代码是你写的,你完全可以把代码写得更好,从而避免交通事故的发生,不要说你写的代码已经好过人类驾驶汽车了,你需要和其他自动驾驶汽车厂商比较,比如,为什么 A 厂商生产的车就不撞人,而 B 厂商生产的却撞人了?

总而言之,你厂商总是可以通过你的努力来降低事故发生的概率 P 的,哪怕你把这个撞人的概率 P 已经做到行业最低了,那你厂商和我这个车主比起来,厂商还是那个有所作为的一方,而车主做什么都改变不了 P,所以一旦撞人了,应当由厂商负责,论证完毕。 这个论证依然建立在预设车主相比厂商控制不了自动驾驶汽车。

批评

这对厂商非常不公平!

在传统的人类驾驶的情况下,这个车子撞了人,这个责任是由司机承担的,这事儿本来是厂商没关系的。而现在呢,这个厂商花了大量的资金和精力去研发出造成伤亡更少的自动驾驶汽车,让你们车主撞的人更少了,至少降低了 90%,本来你们车主为此要赔好多钱,甚至要坐牢,甚至会把自己也给撞死,现在,由于厂商的努力,撞人事故降低了 90%,这事儿你们车主应当给人家厂商送锦旗、戴大红花的,结果你们现在反而要让厂商来担责,出了事故要让厂商来赔钱。天底下没这种道理的。

厂商改变了包括车主和行人在内的所有人的境遇,却因此让自己的境遇更差,这是不公平的。就是我为你们做了一件好事以后你们却把本不属于我的责任甩给我,这进一步会造成自动驾驶汽车这个产业,是自戕的,就是自我矛盾,自己会打败自己。

责任由车主承担

车主具有操控权,能够控制车

真的是无法控制的吗?你真的只是作为一个乘客在乘坐这辆车吗?

车主作为发号施令者:那请问,是谁给这辆车下达命令,比如说让它走成华大道,最终才导致它在成华大道撞了人的呢?你说我让它去成华大道是去送我,不是让它去撞人,但是,你说你不想撞人,那车也不想。这就相当于,一个军队里的指挥官给士兵下达任务,比如说去某村庄去消灭恐怖分子,结果在消灭恐怖分子的过程中误杀了平民,那这个指挥官就可以说这事儿不是我亲手干的,所以指挥官就可以不承担责任了?

车主能够控制车速等关键参数:而且,这车受车主控制的地方还有很多,比如车速,这车可以慢点儿开,但是你非得给车下达一个指令,说我开会要迟到了,请你以最快速度把我送到公司,开快车的决定是车主下达的,那根据惯性定理,开快车更容易躲闪不及而撞人,那这时候当然应当由下达开快车指令的车主来承担责任。而且,你为什么要命令车走成华大道?你难道不知道成华大道人多车杂?那条道就容易发生交通事故,你为什么不命令车从别的路绕过去呢?这都是你车主这个指挥官要尽的义务,那一旦你这个义务没尽好,出了事当然由车主承担责任。当然,除非是这车不听你使唤,就是失灵了,那这时候它撞了人确实不是车主的责任,这就算是产品有重大设计缺陷,这就属于是产品责任,那这就是厂商的责任,这不用自动驾驶汽车,传统人类驾驶汽车由设计缺陷造成交通事故也是厂商负责的,但是,如果不能证明有明确的设计缺陷而导致的意外交通事故,那就应该由这辆车的所有者来承担责任。

另外,关于那个算法的道德歧视的问题,就是如果遇到非得撞两个人中的其中一个,到底是优先保护老人还是小孩,男人还是女人的问题,还是同样的道理,可以在每辆车上设置一个道德旋钮,让每个车主自己去选优先保护哪种人。不要认为这听起来很搞笑,因为如果算法不可避免地存在歧视,在这种二选一的极端状况中,总是不可避免地要设置优先级,那么与其让厂商来设置,不如就把这个设置权交给每个车主,这样做的好处就是,一旦撞了人以后,那么这个车主就自然需要承担责任了,比如说这个优先保护女人是你车主自己设定的,那么那个男人被撞了以后,自然就应当由你车主来负责。

车主是车辆的负责人:你是车主,你是这辆车的 owner,自从你花钱把车从 4S 店里面买回来的那一刻,这辆自动驾驶车是你的,他是你的工具、你的奴隶,那如果这台属于你的车撞了人的话,那当然应当是由这辆车的所有者来负责。你作为车主,你在买它的时候,知不知道根据物理学,这玩意就算厂商把它制造得再完美无缺,它还是会存在一定概率会撞到人,你知不知道有这么个小概率会发生的情况,如果知道你还坚持要买,那它如果真的撞了人的话,对不起,你作为车主就需要为此负责。

车主享受了最大的好处,权利和义务对等:车主享受了哪些本来没有的好处呢?当然,最明显的一个,我们一开始就说了,自动驾驶减少了 90% 的交通事故,这也是我们想要发展自动驾驶的一个最大的好处,而这个最大的好处是厂商受益,还是车主受益?当然是车主,你车主不用赔付那么多钱了,你车主也不用为撞死人而坐牢了,你车主甚至自己也不会被撞死了,这个最大的好处是落在车主身上的。

那除了减少交通事故给车主带来的好处,还有就是因为自动驾驶而带来的好处,你车主不用自己开车了,而且自动驾驶的普及让交通更通畅,也不堵车了,等等等等自动驾驶带来的好处,都是落在了车主头上的,所以你车主享受了这么多自动驾驶带来的好处,那么相应地,自动驾驶带来的一些小小小的坏处,就是它很小概率地会撞到人,车主也必须承担这个风险。这就好比说呢,有两款车让一个消费者来选购,A 车是人类驾驶,并且有 1% 的概率会撞到人,而且这个撞人的责任肯定是由车主承担的,还有另一辆 B 车,它是自动驾驶,撞人的概率已经下降到万分之一,那一个理性的车主肯定会购买 B 车,但你不能购买了 B 车以后,万一碰上了这个万分之一概率的撞人事故,你说这点责任我都不想承担了,你这不就是既要又要了,天底下没这样的道理的。

总之,算车主派在这里的思路就是,享受更多的权益的同时必须承担相应的责任,在此基础上呢,算车主派还主张,我们还可以进一步为车主赋予更多的权益,这样就能更顺理成章地让车主承担责任,从而也就弥合了责任鸿沟。

批评

道德运气问题:也就是凭什么我倒霉,我买的车撞人了,而其他同款车主的车都没撞人,那让我来承担责任,我凭什么,我觉得不公平,因为我买这款车和其他车主花的是一样的钱,我和其他车主比起来没有任何过错,凭什么就我的车出事了,还让我来负责?

道德舆论问题:关于优先保护车主的问题,虽然车主们很乐意,但这会造成极大的社会舆论的压力,而且它也是违反伦理直觉的,就是凭什么?你们车主的命是命,我们路人的命就不是命了?路人的生命权凭什么比车主要低? 同时,设置男女,黑人或白人,小孩或承认,都是给了车主自主权,这相当于让每个车主自己驾驶汽车了。

责任由汽车承担

随着科技的发展,以前认为科幻的东西就会成为现实。包括以前旧有的伦理、法律,都要进行调整以适应科技的发展。现行法律的基本精神,就是只有自然人才可以是法律意义上的最终主体,虽然,有些非自然人,比如像公司、机构这一类法人和非法人组织也可以作为主体,但这些法人和非法人组织最终还是要落实到自然人之上。

AI 能否称为道德主体

自由意志可以由机械唯物主义解释:我们也认为人是有意图、有信念、有自由意志的,没问题,但是问题在于,对于世界上真实发生的事情,我们完全可以不用什么意图、信念、自由意志这种日常的、唯心主义的心灵概念来解释,也能解释得通。就纯粹是物理的,机械的。哈格,由此主张一种归属论(Attributivism ),这些自由意志、主体性只是被人们建构出来的,然后把它归属到人身上的,关键词是归属 attribute,也就是我们把主体性归在了某人头上、算在了某人头上。主体性,是一个归属的问题,在本体论上,人的主体性和其他东西的主体性没有本质区别,而之所以我们说人有自由意志、有主体性,是因为我们把主体性归给了人。那既然自由意志和主体性并不是客观实在的,而是我们归属的产物,那么我们可以把主体性归给人,这也就意味着,理论上主体性就可以被归属到任何东西上,可以是人,可以是动物,可以是上帝,可以是公司,当然也可以是自动驾驶汽车。

有没有必要将责任归属于 AI

主体性归属给复杂事物能很好的解释和预测复杂系统的行为:比如说,张三之所以给这期节目点赞投币,是因为他想要给这个视频点赞投币,这就是我们对张三这个人使用了意向立场,把张三看做了一个有自己的意图、有自由意志的人。这样说就很简洁高效,你一听就懂。

如果不对张三的行动使用意向立场的话,这个话就没法说了,就会变得非常冗长而且低效,之前已经说过,张三的视觉神经受到了来自手机屏幕里面的特定光源的刺激从而形成的特定的电信号,然后这个电信号传输到张三的脑部的前额叶皮层,激发了张三的前额叶皮层此前已经搭好线的 X 神经纤维,然后这个 X 神经纤维又进一步激发了控制张三的手指运动的 Y 神经纤维,然后 Y 神经纤维对张三的中枢神经系统下达了一条命令,这条命令最终传递到张三的手指上,导致张三的手指做出了相应动作。

这么说都是正确的、真实的,但这样人与人之间就没法说话了,而且这对预测张三以后的行动也没有太多帮助,但如果我们用意向立场的话,就很好预测了,我们就说,张三这个人,就喜欢看这一类的哲学讨论的视频节目,下一回他如果再看到这一类的节目,他还是会想要点赞投币的。

接下来说一说 AI,我们需不需要对 AI 使用意向立场?当然要,现在不是有不少人已经对自己家里的扫地机器人采取意向立场了,认为这个扫地机器人就像一个家庭成员一样,那对那种更为复杂的 AI,对它使用意向立场,能给我们带来更大的好处,就是让我们用非常精简易懂的语言来解释和预测它的行动。比如说,我和 AlphaGo 下围棋,它赢了我,那么我们问,它怎么赢的呢?我们不会说,这个 AlphaGo 的 CPU、GPU 里的晶体管发生了什么什么样的物理运动,调取了它多年来的通过深度学习方法训练而得出了一套神经网络,然后综合各种概率计算才走出了这一招棋。我们不会这么说,我们会说:AlphaGo 非常会下棋,并且它想要赢得这局棋,于是它走这一个妙招,把我打败了。这么说非常经济、非常省事儿。

后果论比报应论更适合现在:哈格认为,这个报应论,是一个错误的、并且已经过时了的学说,哈格是站后果论,而批评报应论的,那报应论错在哪儿呢,报应论是向后看的,也就是向过去看的,就是你过去做了什么错事,你过去应当不这么做,所以我们需要你担责受罚,但是,过去是可以改变的吗?过去是改变不了的,我们能改变的,是未来,因此我们不应当采报应论的立场向后看,而要采取后果论的立场向前看、向未来看,看看在未来会造成什么后果。

报应论:我们让一个人担责或者受罚,是他该着就要受罚,因为他做错事了,所以他就应当受罚,其实这也就是我们老百姓讲的「以牙还牙、以眼还眼」或者「杀人偿命」,你如果杀了人了,你就要偿命,哪怕你偿命了对谁都没有好处,但是你就是应当偿命。 后果论:我们让一个人担责或者受罚,是为了在未来能带来更多的好处,或者造成更少的伤害,比如说,预防犯罪,我们惩罚一个小偷,是为了让他以后不敢偷了,以及让其他本来打算盗窃的人看到,盗窃还要受罚的,那我也别盗窃了。

之前有人质疑的,就是我们也不能从大卸八块一台智能机器的过程中感受到告慰,这就是一种报应论的思路,这是错误的,我们让自动驾驶汽车担责受罚是为了打击报复智能机器吗?当然不是,我们赋予自动驾驶汽车以主体性,并让他承担责任,是为了让它以后的行为变得更好,如果犯了错,比如说撞了人了,我们就要让它担责受罚,为的是吸取教训,以后不要再撞人了。那有人问了,这 AI 机器人怎么知道自己应该吸取教训,这就是一个编程问题,大概意思就是,程序员在写代码的时候就写进去「如果我犯错了我就要担责受罚」,就有点机器人三定律那意思,把它写在代码里面,然后这台 AI 机器人就会更加在意不要犯错,比如就更加在意不要撞了人,然后,这进一步就会启动一种遗传进化,就是一旦撞人了,我就要担责受罚,然后为了避免担责受罚,我就进一步避免撞人,这不就使得自动驾驶汽车的安全性越来越好。

AI 人工智能不仅是能够具有主体性因而是能够承担责任的,因为主体性是被归属出来的,而且,我们把主体性归属给 AI 也是有好处的,它能让我们能用更简洁易懂的语言解释和预测 AI 的行动,并且,AI 承担责任也能够使得 AI 以后的行动变得更好。

批评

主体性归属给物体很奇怪:一般而言,一个东西能否成为道德主体,有两个标准,也就是看它是否具有两个 S,Sentience 和 Sapience,暂且把 Sentience 叫做「感受」,把 Sapience 叫做「感知」,什么是感受 Sentience 呢,就是我们以一种第一人称视角亲身感受到一种感觉,比如说感受到一种疼痛,这种感受用语言无法完全描述,有哲学家把这种感受的能力叫做感受质。那什么又是感知 Sapience 呢,就是动用更高级的智力进行思考的能力,比如推理、反思,以及具有自我意识。

主体性归属给物体需要足够复杂,目前造不出来,没啥用:即便按照哈格的这个说法,主体性是被外在赋予的,即便我们承认,最终我们就会造成一台看起来好像真的具有人格的 AI,以至于我们很难不把主体性归属给它,但是,前提是还是需要我们来把主体性归属给它,它还是要表现的足够复杂才行,比如说,这台自动驾驶汽车要表现得真的好想害怕惩罚一样,那我们才会觉得把道德主体性赋予给它是一件不奇怪的事情。但是,造出这种看起来真的害怕惩罚的机器,就算理论上可行,但技术上实现起来太难了,在可预见到的未来都实现不了,所以对于这种只是理论可行,但在可预见到的未来都无法实现的东西,这就类似于科幻了,那这种科幻的看法,你提它没有用。

搁置派

能解决责任鸿沟问题,对于想确定责任主体的观点认为是过时的:这种旧伦理的实质是啥呢,就是「找坏人」,一旦发生了什么意外的事故,唉非得找出一个坏人来背锅,这也属于是一种过时的阴谋论的思想,坏事为什么会发生呢,肯定是有个坏人有在故意使坏,那即便不是他坏,也是因为他蠢,反正非蠢即坏,都怪他,解决掉他就解决问题啦。但是,「找坏人」的旧伦理已经完全不能适应 AI 时代了,如果自动驾驶汽车撞人了,你非得说清楚责任算谁的,你是说不清楚的,就像上述几个派别的争论,到底是算厂商的还是算车主的还是算汽车的,都有道理,也都没道理,说不清楚的,所以问题恰恰就在于,你们为什么非得说清楚呢?你们从一开始就被否决派带错节奏啦,责任鸿沟的问题我们无视它就好了,这个自动驾驶汽车撞人了就撞了,干非得找个谁来背锅呢?

当然,这并不是说,撞了人就不赔钱,撞了人还是要赔钱的,但这不要扯这是谁的过错,也不说这钱到底是谁该出,直接赔钱就好了。那么钱从哪儿来呢?搁置派认为,这个技术层面的事情很好操作,比如说,大家都约好了,这个钱呢,统一由厂商出,你卖车的时候价格稍微卖贵一点点,把要用来赔的钱摊在里面,或者由全体车主统一出,或者就是厂商和车主都交一笔税给政府,一旦撞了人,这个钱由政府出,政府出也就是所有人都出了,也就是没人出。总之,就是要模糊化掉到底应该由那个具体的自然人来负责的问题,没有哪个具体的主体来负责,反正把钱赔了就好了。

能解决道德运气问题:如果我们不追究任何特定主体的道德责任的话,这同时也解决了之前提到过的道德运气的问题,就是如果让车主担责的话,这个车主什么事情都没做,凭什么十万分之一概率撞人的事儿发生在他买的这辆车上还让他承担责任,这显然是不公平的。那如果让厂商来承担其实也有这个道德运气的不公平的问题。那搁置派主张不需要找谁来担责了,这个道德运气问题不就也被搁置掉了。

你听了搁置派的这这一看法,可能会觉得,这种新伦理,有点违反人的直觉,也太让人异化,让人活得太扭曲了,我们人就是有一些出于本能的道德直觉和道德情感,一个无辜的人被撞死了,我们当然本能地就要找到到底是谁犯错了,这种道德本能,你搁置派怎么能说搁置就搁置掉了?

搁置派会说:人,其实根本没有什么不变的道德本质,人的伦理道德一直都是在变化的、一直在变异的,这就是道德进化,技术进步导致人的生存环境变了,那人的伦理道德就会跟着变化,否则人类社会就无法发展了。

举个最简单的例子,现在人人都有一部智能手机,但是,很少有熟人之间不在微信上先打招呼就直接打电话了,现在谁会给我们的手机直接打电话呢?快递员、外卖小哥、各种推销的,或者就是电信诈骗才会给我们直接打电话,而熟人之间如果直接打电话,则是一种让人反感的不礼貌的行为,因为这是要求你当场就要对对方做出回应。但是,这条规矩、这种伦理道德,是最近这几年才有的,以前没有微信、没有 Facebook 的时代,哪儿有这种伦理呢。

其实,人本来就一直都是一种不停地扭曲着自己的动物。你如果非得说人要按照所谓的本性而生活,那人还生活在一切人反对一切人的丛林社会中呢,英国哲学家霍布斯在他的名著《利维坦》中就提出了社会契约论,就说呢,过去的人每个人都是自己权益的直接捍卫者,

批评

对搁置派批评主要是来自于我们最开始介绍的否决派,我们之前也说了,在局部上,算厂商派和算车主派是针锋相对的,在一个更高的层面,否决派和搁置派是针锋相对的。所以对搁置派的批评主要是来自于否决派的。

人性并不是说变就变的:哪怕这个自动驾驶技术,能从整体生提升人类的效用,比如让交通伤亡更少,但是它的代价如果是让我们人类社会的伦理道德、法律体系,被扭曲得不符合人性了,那我们宁愿不要提升这些效用。这是科技对人的异化。

一旦人成了手段,科技成了目的,这就会造成什么呢?这就会造成人本主义的消解,造成「人之死」,我们人就不再是作为一个个活生生的、有血有肉的人儿活在这个世界上了,一旦科技成了目的,我们所有人就成了现代科技造就的大机器或者大系统中的小小的组件,我们是匿名的、平庸的、无需承担任何责任的机器组件,道德主体被取消了,也就是说人本身这个概念已经死了,我们只是为了维持系统运作的组件而已,比如自动驾驶汽车撞死人了,这个只是现代大机器运行的一个小小的 bug,这跟任何机器组件都无关,这事儿没有任何人做错什么,这只为了维护大系统而不得不牺牲掉的人,系统整体给他赔钱就行了,系统还是要继续进化的。而自动驾驶技术的发展,就是这种科技对人的异化。

并不能解决道德运气问题,有负罪感:我作为一个人类司机,哪怕我完全遵守交通规则,但是撞死了一个横穿马路的小孩,哪怕从交规上来讲完全是对方的过错,我不用承担任何法律责任,也不用赔任何钱,这完全就是运气问题,简单说就是倒霉,但是,我也不可能做到跟个没事儿人一样,我会摆脱不掉地有一种第一人称的行动者憾恨,我会过意不去,会难过,会遗憾,会悔恨,毕竟这孩子是死在我开的车底下的。那这种行动者憾恨就是一种人类的道德直觉,意思就是说,哪怕我没有任何过错,但运气是摆脱不掉的,我出于运气而撞死了一个孩子,我就是搁置不掉这种憾恨。

参考资料

- 大问题:自动驾驶汽车撞了人,责任算谁的?

- Nyholm, S. (2018). The ethics of crashes with self‐driving cars: A roadmap, I&II. Philosophy Compass, 13(7), e12506.

- Brożek, B., & Jakubiec, M. (2017). On the legal responsibility of autonomous machines. Artificial Intelligence and Law, 25(3), 293-304.

- Gurney, J. K. (2017). Applying a reasonable driver standard to accidents caused by autonomous vehicles. Robot ethics 2.0: From autonomous cars to artificial intelligence, 51.

- Hage, J. (2017). Theoretical foundations for the responsibility of autonomous agents. Artificial Intelligence and Law, 25(3), 255-271.

- Hansson, S. O., Belin, M.-Å., & Lundgren, B. (2021). Self-Driving Vehicles—an Ethical Overview. Philosophy and Technology, 34(4), 1383-1408.